Apa Itu Stream Processing?

Stream processing adalah teknik pengelolaan data streaming yang memungkinkan kita mengolah data secara terus-menerus (real time) — mulai dari proses analisis, filtering, transformasi, sampai pengayaan data — langsung saat data masuk. Setelah diproses, data bisa dikirim ke aplikasi lain, data store, atau mesin stream processing lainnya.

Popularitas arsitektur dan layanan stream processing terus naik karena teknologi ini memudahkan integrasi berbagai sumber data seperti transaksi, feed saham, analitik website, perangkat IoT, database operasional, laporan cuaca, dan layanan komersial lainnya.

Konsep dasarnya sudah ada sejak lama, tapi sekarang makin mudah diterapkan berkat banyaknya tools open source dan layanan cloud yang tersedia.

Bagaimana Cara Kerja Stream Processing?

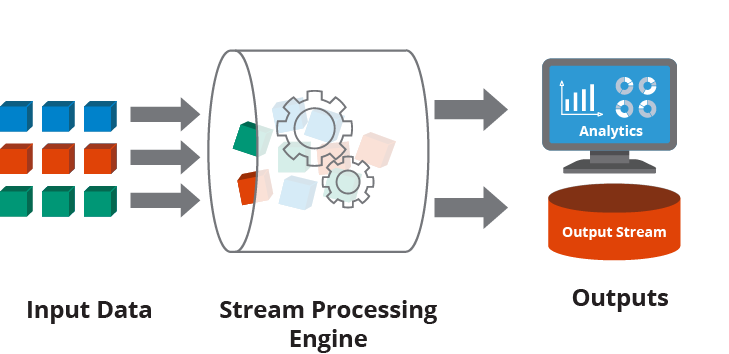

Arsitektur stream processing dirancang untuk menyederhanakan proses manajemen data secara aman dan efisien. Proses dimulai dari mengonsumsi data dari layanan publish-subscribe, lalu melakukan berbagai aksi seperti analisis, filter, transformasi, penggabungan, atau pembersihan data. Hasil akhirnya kemudian dikirim kembali ke layanan publish-subscribe atau ke storage lain.

Engine stream processing mengemas data dalam bentuk event kecil (mini-batch) dan menyajikannya secara berkesinambungan ke aplikasi lain. Ini bikin logika pemrosesan data lintas waktu dan sumber jadi lebih simpel untuk developer.

Stream processing memungkinkan pengelolaan data secara real time dalam bentuk stream berkelanjutan.

Kenapa Stream Processing Penting?

Stream processing dibutuhkan untuk:

- Mengembangkan aplikasi yang adaptif dan responsif

- Memperbaiki analitik bisnis secara real-time

- Mempercepat pengambilan keputusan

- Meningkatkan akurasi keputusan karena data lebih kontekstual

- Meningkatkan user experience

- Membangun aplikasi baru yang terintegrasi dengan berbagai sumber data

Bagaimana Stream Processing Digunakan?

Tools modern stream processing dikembangkan dari berbagai framework publish-subscribe yang menyederhanakan pengolahan data saat transit. Penggunaan stream processing juga dapat menekan biaya penyimpanan dan transmisi data karena sebagian proses bisa dilakukan di edge (dekat dengan sumber data).

Arsitektur streaming data juga memudahkan integrasi antar aplikasi bisnis dan sistem operasional. Contohnya, penyedia layanan telekomunikasi menggabungkan data dari banyak sistem pendukung operasional; di bidang kesehatan, data dari sensor medis, perangkat monitoring, dan rekam medis elektronik bisa digabungkan jadi satu aliran.

Contoh penggunaan stream processing antara lain:

- Deteksi fraud

- Pendeteksian kejadian anomali

- Optimasi fitur aplikasi bisnis

- Manajemen data lokasi

- Personalisasi pengalaman pelanggan

- Trading di pasar saham

- Monitoring dan respon insiden IT

- Pemetaan customer journey

- Monitoring digital experience

- Prediktif analytics

Framework Populer untuk Stream Processing

Beberapa framework open source yang populer buat stream processing adalah Spark, Flink, dan Kafka Streams. Layanan cloud besar juga punya layanan native seperti Amazon Kinesis, Azure Stream Analytics, dan Google Cloud Dataflow.

Semua ini bisa diintegrasikan dengan sistem publish-subscribe lain. Misalnya, Apache Kafka adalah framework populer untuk menghubungkan aplikasi dan data store. Kafka Streams memungkinkan developer membangun aplikasi stream yang membaca data dari Kafka, memprosesnya, lalu menulis hasilnya kembali ke Kafka untuk digunakan aplikasi lain.

Tools lain yang juga mulai banyak digunakan:

- Apache Samza: untuk aplikasi stateful secara distributed.

- Apache Storm: mendukung pemrosesan real-time seperti online learning dan reinforcement learning.

- Delta Lake: mendukung stream dan batch processing dengan arsitektur terpadu.

Perbedaan Stream Processing dan Batch Processing

Stream processing dan batch processing adalah dua paradigma berbeda dalam manajemen dan pengembangan aplikasi data.

Batch processing dulu digunakan untuk memproses data dalam jumlah besar yang sudah dikumpulkan, misalnya laporan penjualan bulanan atau penggajian bulanan. Cocok untuk tugas-tugas terjadwal yang sudah pasti batasannya.

Stream processing memungkinkan pemrosesan data secara kontinu. Walaupun data tetap masuk dalam bentuk mini-batch, stream engine akan menangani filtering dan tracking internalnya sendiri. Ini membuat tim data engineer dan developer bisa lebih fokus ke logika aplikasi atau analitik.

Sejarah Stream Processing

Konsep pengolahan data waktu nyata sebenarnya sudah dibahas sejak awal perkembangan komputer. Dahulu disebut sensor fusion. Di awal 1990-an, Prof. David Luckham dari Stanford memperkenalkan istilah Complex Event Processing (CEP) yang melahirkan konsep seperti Service-Oriented Architecture (SOA) dan Enterprise Service Bus (ESB).

Prinsip CEP antara lain mencakup pengelolaan waktu event, hierarki event, dan hubungan sebab akibat antar event. Seiring berkembangnya layanan cloud dan software open source, muncullah pendekatan yang lebih ringan dan efisien melalui publish-subscribe seperti Kafka, yang akhirnya membuka jalan untuk framework stream processing modern.

Meski istilah seperti SOA, ESB, dan CEP mulai ditinggalkan, konsep dasarnya tetap hidup dalam bentuk microservices, pub-sub, dan stream processing saat ini.